通向AGI的钥匙:100,000H100非常AI算率集群

- AIGC

- 2024-10-16

- 839热度

- 0评论

自GPT-4发布以来,全球AI能力发展势头有所放缓。

但是这并不意味着Scaling Law失败,并非因为训练数据不足,而是因为它遇到了一个结实的算率瓶颈。

具体来说,GPT-练习算率约为2e25。 FLOP,最近发布的GoogleGeminini等几个大型模型 Ultra、Nvidia Nemotron 340B、还有Meta Llama3 在405B背后使用的练习算率大致相当于GPT-4,没有质的提高,所以模型的新能力无法解锁。

为成为AI时代的造物主,OpenAI/微软、xAI、像Meta这样的科技巨头正在争相建立一个由10万元H100组成的超级AI算率集群。

如果你想实现这个目标,光有钱是远远不够的。它涉及许多技术问题,如能源挑战、网络拓扑结构、可靠性保证、并行计划、框架布局等。

这类技术难题是人类通往AGI的障碍,同时也孕育了巨大的投资机会。

最近,SemiAnalysis发布了一份名为“100,0000”的重磅深度报告 H100 Clusters: Power, Network Topology, Ethernet vs InfiniBand, Reliability, Failures, Checkpointing》,对于这个话题进行分析,高度认可。

接下来我给大家解读一下这个大报告。报告链接放在文末,欢迎有兴趣的朋友阅读原文。

我先列出主要结论,然后再开始进行:

AI公司的生死线由GPU数量决定。目前AI公司第一梯队的门票是32,000卡集群,明年第一梯队的门票可能会增加到100,000卡集群。

由10万张H100组成的AI集群功耗约为150MW,超过40亿美元的资本支出,电费每年高达1.2亿美元。

为了满足下一代万亿参数、多模式、大模式的训练,需要精致的网络拓扑结构设计,综合利用数据并行、张量并行、流水线并行等技术进行分布式训练。

为防止Nvidia支付高额费用? Tax,越来越多的Hyperscaler开始选择博通的Tomahawk 建立自己的非常AI集群,而不是Nvidia的Spectrum-X,未来博通的网络收益将继续飙升。

接下来我们正式开始。这篇文章有点硬核,建议耐心阅读哈。

(1)AI Infra的现状:一边铺设轨道,一边快速行驶

AI Infra已成为下一代大模型诞生的重要瓶颈。

有人形容OpenAI的内部状态就像一列开拓新世界的火车。科学家负责让火车高速行驶。Infra工程师负责在前面修理铁路。铁路铺装和火车行驶齐头并进。

据估计,单个非常AI集群的资本支出超过40亿美元,耗电1500美元 MW,每年能耗1.59TWh。按照0.078美元/kWh的标准费率,每年的电费将达到1.24亿美元。

虽然成本极高,但全球科技巨头仍趋之若鹜。

我们来衡量一下由10万卡组成的超级AI算率集群能提供多少计算能力。

在约20,000元的A100中,OpenAI对GPT-4进行了90天的训练,BF16 大约2.15e25,FLOPS FLOP。

该集群的峰值吞吐量为6.28 BF16 ExaFLOP/秒。

由10万元H100组成的超级集群中,这一数字将飙升至1980 FP16 ExaFLOP每秒,增加31.5倍。

利用H100训练万亿参数模型,可实现FP88的高达35% FP16的MFU和40% MFU。

MFU(Model FLOPs Utilization)在测试模型训练过程中,GPU的实际计算能力与其理论峰值之比。该指标反映了硬件资源在大模型训练中的具体计算能力。

100天的H100集群训练,可以达到6e26左右的有效FP8 FLOP。

换句话说,GPT-4的练习只需4天就可以完成。。

(2)AI背后的能源挑战

在计算瓶颈的背后,有两座大山,即“能源”和“工程能力”。

一个由10万元H100组成的集群需要150MW左右的功率。到目前为止,超级计算机El Capitan只需要30MW功率,只有1/5。

这个150MW可以分为H100。 Server内部的功耗,以及H100 Server外部设备配件耗电。

H100 在Server内部,每个GPU本身的功耗大约为700W,CPU为每个GPU配套。、NIC(Network Interface Card)、PSU(Power Supply Units)大约需要575W的功耗。

H100 在Server外部,AI集群还涵盖了许多其它设备,如存储服务器、网络交换机、光收发器等,约占总功耗的10%。

现在世界上还没有一个数据中心有实力部署150MW的AI集群。X.AI 甚至把田纳西州孟菲斯市的一家老厂改造成了数据中心。

这类AI集群通过光通信进行互联,而光通信的成本与传输距离成正比。

多模式SR和AOC收发器的最长传输距离约为50米。

远程单模DR和FR收发器的传输距离为500米~2000米,但是它们的成本是前者的2.5倍。

公园级800G相关光收发器的传输距离可超过2000米,但成本要高出10倍以上。

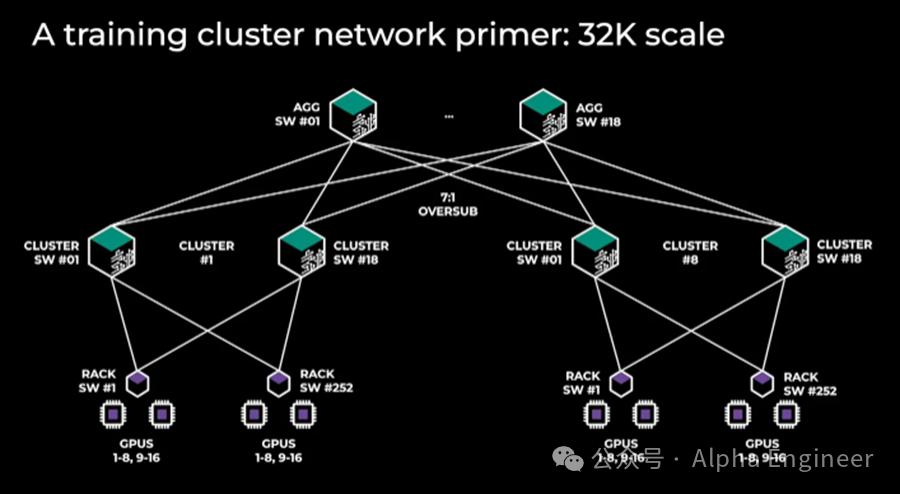

H100集群规模较小的一般做法是,通过1-2层交换机,将所有GPU与400G多模光收发器连接起来。

对大型H100集群而言,需要增加更多层次的交换机,光学设备的成本也将变得十分昂贵。不同的网络拓扑结构将带来完全不同的资金支出。

每个数据中心建筑都可称为计算岛(compute island),其中包含多个“计算仓库”(compute pod),这是一种廉价的铜缆互联的计算仓库。接着是多个“计算岛”(compute island)它们之间通过长距离的光通信进行互联。

当前,在数据中心集中提供150MW功率是相当困难的,因此网络拓扑结构的设计尤为重要。

一些AI公司选择Broadcom Tomahawk 有的选择Infiniband,有的选择英伟达的Spectrum。-X。接下来,我们将讨论原因,并对这些策略的优缺点进行比较。

(3)AI 网络拓扑与并行设计是Infra的关键

要深入了解网络拓扑结构,首先要了解三种不同类型的并行设计方法,即数据并行、张量并行、流水线并行。

数据并行(Data Parallelism)

数据平行是最简单的平行方式,每个GPU都有一个完整的模型权重副本,并接受不同的训练数据子集。

由于GPU之间只需要传递梯度数据,所以这种并行的通信要求最低。

然而,数据并行要求每个GPU都有足够的内存来存储整个模型的权重。这就像 GPT-4 如此拥有18,000亿参数模型,代表10.8万亿参数模型。 内存占用TB。

张量并行(Tensor Parallelism)

每个人都创造了张量并行技术,以克服数据并行带来的内存限制。

张量在多个GPU上并行分配模型每一层的工作和权重,通常沿着隐藏层面进行分割。这意味着每个GPU只处理模型的一部分,而不是整个模型。

在张量平行中,GPU之间需要频繁的通信来交换中间值,从外面看起来像一个巨大的GPU。因此,张量平行需要高带宽和低延迟的网络连接。

每个GPU的内存要求可以通过张量并行有效降低。例如,当NVLink连接使用8个张量并行级别时,每个GPU使用的内存可以减少8倍。

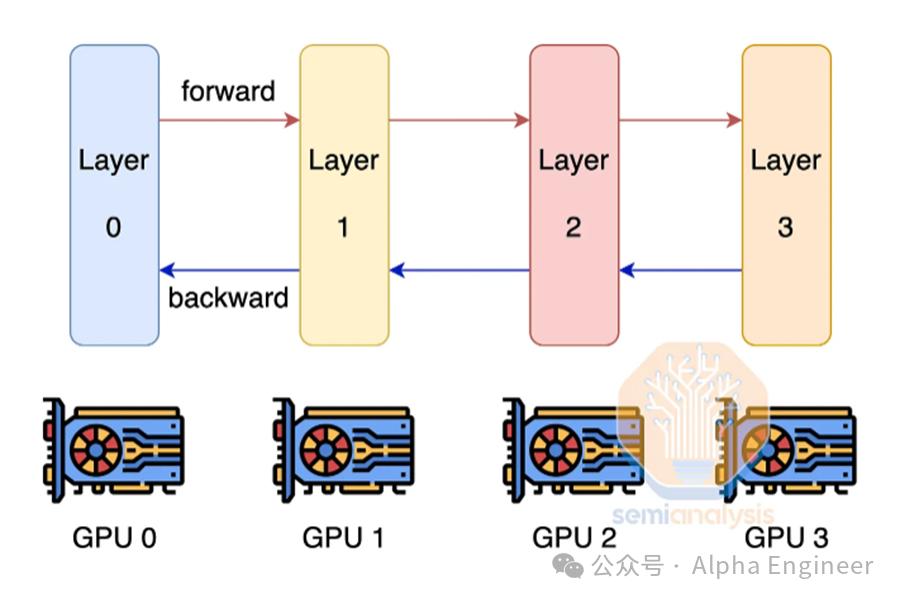

流水线并行(Pipeline Parallelism)

流水线并行技术是克服GPU内存限制的另一种方法。

流水线并行的核心思想是向不同的GPU分配不同层次的模型,每个GPU只负责一部分层次的计算。

当一个GPU完成层的前向和反向传播计算时,中间结果可以传达给下一个GPU,下一个数据批号可以立即开始计算。

由于每一个GPU只有存储模型的一部分层,使用流水线并行技术可以减少每一个GPU所需的内存空间。

然而,它增加了GPU之间的通信量。计算完每个GPU后,需要将数据传输到下一个GPU,这就需要高效的数据连接来支持数据的快速传输。

流水线并行对通信量要求很高,但是没有张量并行那么高。

3D并行(3D Parallelism)

为最大限度地提高FLOP模型的利用率(MFU),Hyperscaler通常将三种并行技术结合起来,形成 3D 并行。

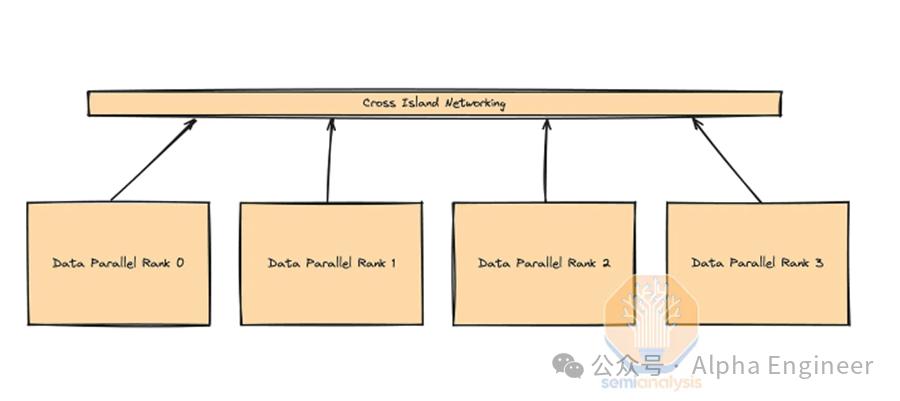

具体做法如下:第一,H100 Server中的GPU使用张量并行,然后在同一个计算岛的节点之间使用流水线并行,最后在不同的计算岛之间使用数据并行。

AI集群设计方案Hyperscalers

了解了并行计划策划之后,我们一起来看看Hyperscalers非常AI算率集群的具体方案。

先看看Meta的设计。如图所示,这是一个计算集群,包括32,000个GPU,共有8个计算岛。

每一个计算岛的GPU都是通过高带宽连接的,而岛与岛之间是通过顶层交换机连接的。

顶层交换机的带宽被故意设计成低于连接到下层交换机的总带宽,这就是所谓的“Oversubscribe",也就是超过带宽订阅。

超过带宽订阅会降低岛屿之间的通信速度,但在实际应用中,由于并非所有服务器都会同时使用最大带宽进行通信,因此通常不会对性能产生很大影响。

带宽过度订阅通过在顶层交换机上实施,平衡了性能和成本之间的关系。尽管这一设计可以限制岛屿之间的通信带宽,但是通过有效的网络管理,可以在降低建设和维护成本的同时,保证整个集群的运行效率。

与Meta相比,Google设计了一种网络结构,专门用于支持大规模TPU计算集群,称为ICICI。(Inter Chiplet Interconnect)。

ICI网络最多可以支持8960个TPU芯片,每个64 在训练过程中,TPU水冷机架之间需要连接昂贵的800G,只使用前端网络。

由于ICI网络只能扩展到一定的规模,Google需要通过不断加强TPU前端网络来弥补这一不足,而不是像GPU集群那样通过增加更多的网络层次来扩展。

(5)AI 炼狱稳定性,Infra

可靠性是AI集群面临的一个重要挑战。

GPU节点在模型训练过程中会不断地停机或报错。GPU报错是常见的。 HBM ECC Error、GPU驱动器卡住,光收发器故障,网卡过热等。

数据中心必须保留热备节点,以确保模型训练的持续性,减少平均故障的恢复时间。

如果出了问题,千万不要停止训练,而是要直接换到工作备用节点继续训练。

在大多数情况下,重启节点可以解决问题。然而,在某些情况下,技术人员需要介入进行物理诊断和更换。

有时候技术人员只需要几个小时就可以修复损坏的GPU,但是在更多的前提下,损坏的节点需要几天的时间才能重新投入训练。

在训练模型时,我们需要经常将模型Checkpoint保存到CPU内存或NAND。 在SSD中,防止HBM。 ECC等错误。

当出现错误时,需要从较慢的内存层重新加载模型权重,并重新开始训练。

但是经常进行Checkpointing会对系统的整体MFU造成损害。集群应该不断暂停,备份和储存当前的权重。

一般来说,Checkpointing每100次迭代一次,这意味着你最多可能会失去99个有用的训练步骤。

如果每次迭代需要2秒钟,在10万卡集群中,如果在迭代到99次时出现故障,你将失去229。 GPU天的工作量。

诸神之战:博通Tomahawk 5 vs Spectrum英伟达-X

目前建设10万个H100超级AI算率集群,有三种网络方案可供选择,即Broadcom。 Tomahawk 5,Nvidia Infiniband,还有Nvidia Spectrum-X。以下我们将详细比较这三种方案的优缺点。

各种AI集群中,Spectrum-与InfiniBand相比,X具有显著的优势,包括性能优势、可靠性和成本优势。

Spectrum-每一台SN5600交换机X以太网都有128个400G端口,而InfiniBand NDR Quantum-2交换机只有64个400G端口。

值得注意的是,BroadcomTomahawk ASIC也支持128个400G端口,这使得InfiniBand目前处于非常不利的地位。

相对于Tomahawk,Spectrum-X的主要优点是它获得了NCCL等Nvidia库的一流支持,而Tomahawkk则是 为了达到最大的吞吐量,你需要进行大量的内部工程设计。

为防止高额支付 Nvidia Tax,越来越多的Hyperscaler开始选择布局Broadcom Tomahawk 5方案。

每个台基于Tomahawkk Spectrum交换机的端口数量-X 同样的SN5600交换机,都是性能相近的128个400G端口。

大多数客户直接与ODM合作,例如Celestica用于交换机,Innolightica用于收发器。、Eoptolink。所以Tomahawk Nvidia的成本远低于5 InfiniBand,与Nvidia相比 Spectrum-X便宜。

但希望Tomahawk 达到和Nvidia Spectrum-X类似的表现,你需要有足够的工程能力来做Tomahawk 提高NCCL通信集群。

Nvidia为Spectrum-X和InfiniBand提供了一个NCCL通信集,可以打开盒子,但是它不适合Boardcom的Tomahawkk。 5。

Jensen一直称Nvidia为软件公司,软件生态为其提供了深厚的环城河。但是现在越来越多的AI公司试图填补自己的工程能力,防止Nvidia支付高额费用。 Tax。

BOM成本计算:10万卡AI集群需要多少Capex?

经过定性研究,我们将尝试进行定量计算。

下面详细计算了4个由H100组成的10万元AI集群设计方案的BOM费用。

这四种方案各有以下几种:

方案1:4层InfiniBand网络,32,768个GPU岛,轨道提升,77:1 oversubscription

方案2:SpectrumX网络3层,GPU岛32,768个,轨道提升,7个:1 oversubscription

方案3:3层InfiniBand网络,24,576个GPU岛,非轨道提升,节点内前端网络。

方案4:Broadcom3层 Tomahawk 5GPU岛,以太网网络,32,768个,轨道提升,7个:1 oversubscription

不难看出,Capex大约有40亿美元,10万元H100非常AI算率集群。。资本支出因选择的网络类型而异。

对比这四种方案,4层InfiniBand网络的成本是其它策略的1.3-1.6倍,这就是为什么没有人愿意选择大型InfiniBand网络。

与InfiniBand相比,Spectrum X提供了更大规模的计算岛,更高的岛间带宽,但是它也带来了很大的成本,也就是更高的功率需求。

我们认为,基于Broadcom Tomahawk 5计算岛和顶层72k计算岛:oversubscription是最具性价比的解决方案,因此,许多公司都在建设类似的网络。

由于Nvidia不需要支付 Tax,在同一TCO(总体成本)条件下,该方案可提供最高的网络性能。

展望未来,随着越来越多的Hyperscaler选择Tomahawkk 5来建立自己的AI集群,博通的网络收益将继续飙升。

(8)结论:AI时代军备竞赛

SemiAnalysis的这篇文章充满了干货和大量的信息。除上述话题外,本文还提到了轨道设计、平面布局、RoCE链接故障、RDMA复制等重要内容,如AI算率集群。 Infra进行了全面深入的分析和展望。

因为篇幅有限,我会把这些内容放在后续的文章中与大家分享。

由100,000张H100卡组成的超级AI算率集群,就像现代人类文明的奇观,是人类通向AGI的关键。

AI时代的军备竞赛已经拉开帷幕,筹码是天量Capex支出,胜者有机会成为AI时代的创造者。

在这场AI军备比赛中,谁将是最后的赢家?

作家:费斌杰 北京市青联委员 熵简技术CEO

(文毕)

本文来自微信微信官方账号“Alpha Engineer”(ID:Alpha-Engineer),作者:费斌杰,36氪经授权发布。